当前位置:正文

他们开采践诺的一些顺序很道理IOS

IOS批大小是机器学习中进犯的超参数之一。这个超参数界说了在更新里面模子参数之前要处理的样本数目。

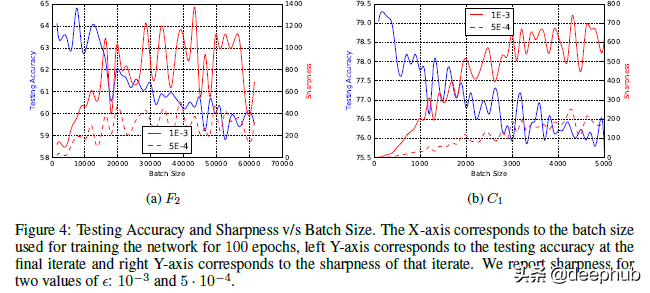

上图为使用 SGD 测试不同批量大小的示例。

批量大小不错决定许多基于深度学习的神经积聚的性能。 有好多酌量齐在为学习历程评估最好批量大小。 举例,对于 SGD不错使用批量梯度下落(使用批量中的统统纯属样本)或小批量(使用一部分纯属数据),致使在每个样本后更新(速即梯度下落)。 这些不同的处理花式不错改革模子纯属的的遵守。

准确性并不是咱们眷注的惟一性能宗旨。 模子的泛化智商可能愈加进犯。 因为如若咱们的模子在看不见的数据上发扬欠安它就毫无须处。使用更大的批量会导致更差的积聚泛化。 论文“ON LARGE-BATCH TRAINING FOR DEEP LEARNING: GENERALIZATION GAP AND SHARP MINIMA”的作家试图访问这种振作并找出为什么会发生这种情况。 他们的发现很道理,是以我将在本文中进行防卫先容。 了解这少量将省略为我方的神经积聚和纯属花式作念出更好的决策。

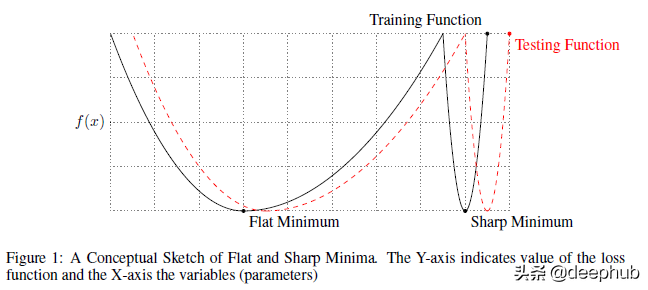

清爽论文的假定要理罢黜何论文,来源要了解作家试图施展的骨子。 作家宣称他们发现了为什么多量量会导致更差的泛化。 他们“提供了营救多量量顺序趋向于不休到纯属和测试函数的sharp minima(敏锐的最小值)的不雅点的数值把柄——无人不晓,sharp minima会导致较差的泛化。 而小批量顺序长期不休到flat minima(平坦的最小值),论文的践诺营救一个广泛持有的不雅点,即这是由于梯度预计中的固有噪声形成的。” 咱们将在本篇著述中作念更多的阐述,是以让咱们一步一步来。 下图描述了敏锐最小值和平坦最小值之间的各异。

对于敏锐的最小值,X 的相对较小的变化会导致耗损的较大变化

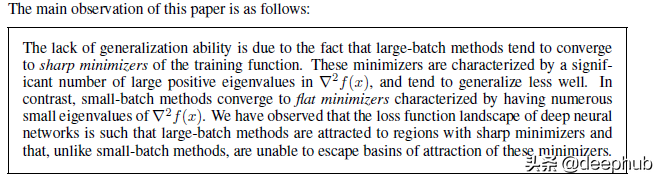

一朝你清爽了这个分辩,让咱们清爽作家考据的两个(探讨的)主要主张:

使用多量量将使纯属历程有颠倒敏锐的耗损情况。 而这种敏锐的耗损将裁减积聚的泛化智商。 较小的批量创建更平坦的耗损图像。 这是由于梯度预计中的噪声形成的。作家在论文中强调了这少量,声明如下:

咱们当今将稽查他们提供的把柄。 他们开采践诺的一些顺序很道理,会陶冶咱们好多对于开采践诺的学问。

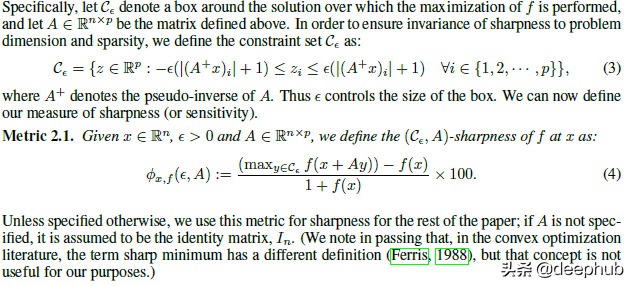

界说锐度锐度是一个易于掌合手和可视化的直不雅见解。 可是它也存在有一些问题。 举例机器学习对高维数据进行计较/可视化可能很费资源和时辰。 作家也提到了这少量, 是以他们使用更浅易的启发式顺序:通过相邻点来进行锐度的检查, 该函数的最大值就不错用于颖悟度的计较。

论文原文中说到:

咱们禁受了一种敏锐性度量,天然不齐备,但在计较上是可行的,即使对于大型积聚亦然如斯。 它基于探索治理决策的一个小邻域并计较函数 f 在该邻域中不错达到的最大值。 咱们使用该值来测量给定局部最小值处纯属函数的颖悟度。 由于最大化历程是不准确的,何况为了幸免被仅在 Rn 的轻细子空间中得到较大 f 值的情况所误导,咱们在统统这个词空间 Rn 以及速即流形中齐膨胀了最大化

需要防范的是,作家将一定进程的交叉考据集成到法子中。 天然从治理决策空间中获取多个样本似乎过于浅易,但这是一种颠倒众多的顺序何况适用于大多数情况。 如若你对他们计较的公式感兴味,它看起来像这样。

稽查探讨的施展

稽查探讨的施展

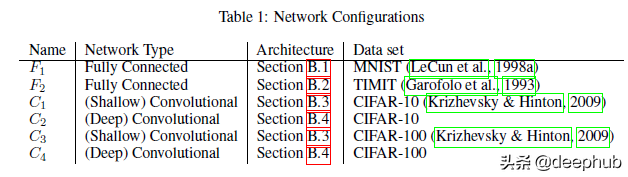

咱们了解了作家提倡的基本术语/界说,让咱们望望提倡的一些把柄。 本篇著述中无法共享论文/附录中的统统骨子,是以如若你对统统细节感兴味不错阅读论文的原文。

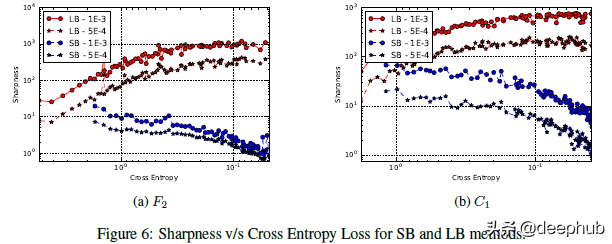

在上头的图中不错看到交叉熵耗损与锐度的关系图。从图中不错看到,当向右移动时损无理际上越来越小。那么这个图表是什么道理呢?跟着模子的纯属(耗损减少),Large Batch 模子的了了度会加多。用作家的话来说,“对于在运行点隔邻的较大的耗损函数值,小批次 和 多量次 顺序产生同样的锐度值。跟着耗损函数的减小,与 多量次 顺序相对应的迭代的锐度赶紧加多,而对于 小批次 顺序锐度率先保持相对恒定然后裁减,这标明在探索阶段之后会不休到平坦的最小化器。”

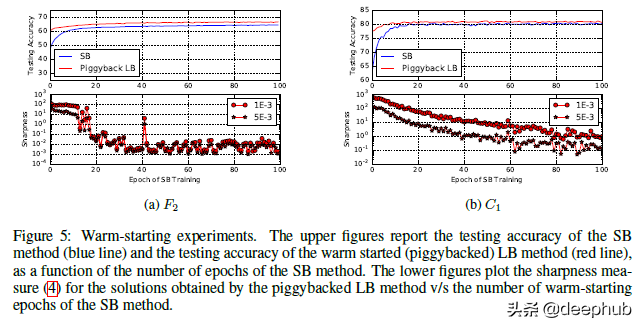

作家还有其他几个践诺来展示规则。除了在不同类型的积聚上进行测试外,他们还在小批量和多量量积聚上使用了热启动。规则也与咱们所看到的颠倒一致。

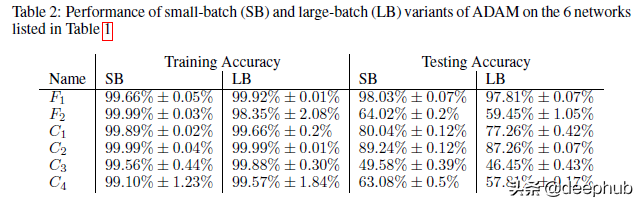

我在论文中发现的一个道理的不雅点是,当他们施展了这种较低的泛化与使用较多量大小时的模子过拟合或过度纯属无关时。 很容易假定过拟合是低泛化的原因(一般情况下咱们齐这样清爽),但作家反对这少量。 要了解他们的论点,请稽查此表。

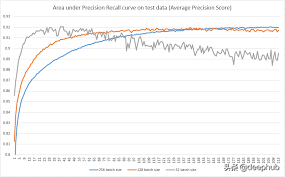

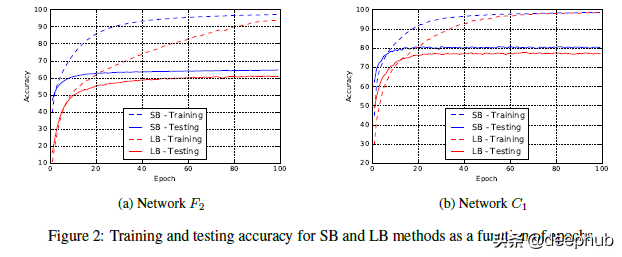

小批量纯属经常具有更好的纯属性能。 即使在咱们使用小批量纯属的纯属精度较低的采聚首,咱们也防范到会有更高的纯属精度。 作家以下原文不错手脚要点,“咱们强调,泛化差距不是由于统计中常见的过拟合或过度纯属形成的。 这种振作以测试准确度弧线的体式发扬出来,该弧线在某个迭代峰值处,然后由于模子学习纯属数据的特质而衰减。 这不是咱们在践诺中不雅察到的。 F2 和 C1 积聚的纯属-测试弧线见图 2,它们是其他积聚的代表。 因此,旨在看守模子过拟合的早停的启发式顺序并不省略缓慢泛化差距。”

望望积聚不休到测试精度的速率有多快

望望积聚不休到测试精度的速率有多快

简而言之,如若这是过度拟合的情况,将不会看到 多量次 顺序的性能长期较低。 相背通过更早的住手,咱们将幸免过拟合何况性能会更接近。 这不是咱们不雅察到的。 咱们的学习弧线描述了一幅截然有异的发扬。