当前位置:正文

处治数据以从其固有结构中学习通用版

东谈主们通过凝听和不雅察言语者的嘴唇手脚来感知言语通用版。

那么,AI 也不错吗?

通用版

事实上,计议标明视觉陈迹在语言学习中起着枢纽的作用。比拟之下,东谈主工智能语言识别系统主如若设置在音频上。而且需要无数数据来考研,时常需要数万小时的记载。

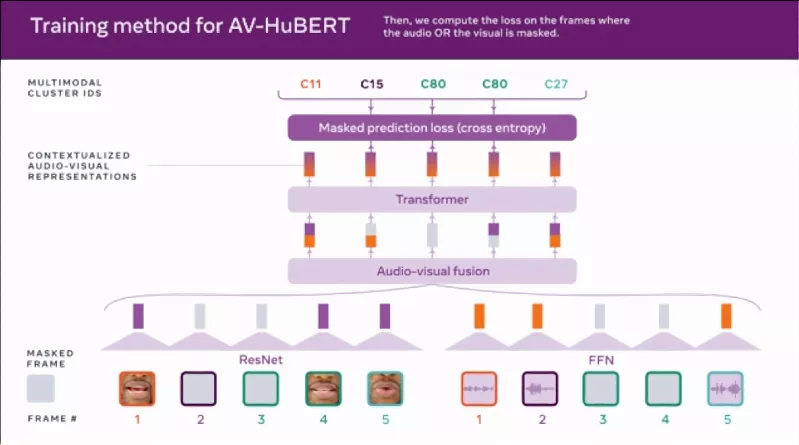

为了计议视觉遵循,尤其是嘴部手脚的镜头,是否不错擢升语音识别系统的性能。Meta 的计议东谈主员开垦了 Audio-Visual Hidden Unit BERT (AV-HuBERT),这是一个通过不雅看学习和听东谈主们言语来清醒语言的框架。

Meta 宣称 AV-HuBERT 比使用相易数目转录量的最好视听语音识别系统准确率高 75%。此外,该公司示意,AV-HuBERT 使用止境之一的象征数据优于已往最好的视听语言识别系统,这使得它可能对音视频数据很少的语言具有潜在的用途。

Meta AI 计议科学家 Abdelrahman Mohamed 示意:“在改日,像 AV-HuBERT 这么的 AI 框架可用于擢升语音识别时间在嘈杂的平日条目下的性能,举例,在约聚上或在连绵继续的街头中进行的互动。智高手机中的助手、增强执行眼镜和配备录像头的智能扬声器,举例 Alexa Echo Show 也不错在这项时间中受益。”

当今,Meta 已将接洽代码开源到 GitHub。

AV-HuBERTMeta 并不是第一个将东谈主工智能应用于读唇语问题的公司。2016年,牛津大学的计议东谈主员创建了一个系统,该系统在某些测试中的准确率真的是教师丰富的唇读者的两倍,而且不错及时地处治视频。2017年,Alphabet 旗下的 DeepMind 在数千小时的电视节目中考研了一个系统,在测试集上不错正确翻译约 50%的单词而莫得子虚,远高于东谈主类大师的 12.4%。

然而牛津大学和 DeepMind 的模子,与好多后续的唇读模子一样,在它们不错识别的词汇边界内受到放荡。这些模子还需要与转录本配对的数据集智商进行考研,而且它们无法处治视频中任何扬声器的音频。

有点私有的是, AV-HuBERT 愚弄了无监督或自我监督的学习。通过监督学习,像 DeepMind 这么的算法在象征的示例数据上进行考研,直到它们不错检测到示例和特定输出之间的潜在关连。举例,系统可能会被考研在涌现柯基的图倏得写出单词「dog」。关联词,AV-HuBERT 自学对未象征的数据进行分类,处治数据以从其固有结构中学习。

AV-HuBERT 亦然多模态的,因为它通过一系列的音频和唇部手脚提醒来学习感知语言。通过聚集言语流程中嘴唇和牙齿的盛开等陈迹以及听觉信息,AV-HuBERT 不错捕捉这两种数据类型之间的眇小关联。

来源的 AV-HuBERT 模子在 30 小时的 TED Talk 视频上进行了考研,大大少于之前首先进模子的 31,000 小时的考研时间。然而,尽管在较少的数据上进行了考研,AV-HuBERT 的单词子虚率 (WER)(研究语音识别性能的缠绵)在不错看到但听不到言语者的情况下略好于旧模子的 33.6%,前者为 32.5%。(WER 的臆测步调是将子虚识别的单词数除以总单词数;32.5% 飘浮为约莫每 30 个单词出现一个子虚。)在 433 小时的 TED 演讲考研进一步将 AV-HuBERT 的 WER 裁汰到 28.6%。

一朝 AV-HuBERT 很好地了解了数据之间的结构和接洽性,计议东谈主员就粗鄙在未象征的数据上进一步考研它。上传到 YouTube 的 2,442 小时名东谈主英语视频,这不仅使 WER 下跌到 26.9%,而且 Meta 示意,它标明只需要极少象征数据来考研特定应用步调(举例,当多东谈主同期言语时)或不同语言的框架。

事实上,Meta 宣称当配景中播放响亮的音乐或杂音时,AV-HuBERT 在识别一个东谈主的语音方面比纯音频模子好约 50%,当语音和配景杂音通常响亮时,AV-HuBERT 的 WER 为 3.2%,而之前的最好多方法模子为 25.5%。

潜在的缺陷在好多方面来看,AV-HuBERT 象征着 Meta 在用于复杂任务的无监督、多方法时间方面支配增长的投资。

Meta 示意 AV-HuBERT 不错为开垦“低资源”语言的对话模子开辟可能性。该公司建议,AV-HuBERT 还可用于为有语言阻挠的东谈主创建语音识别系统,以及检测深度伪造和为假造执行化身生成传神的嘴唇盛开。

在各方面数据上,新步调的变现确凿很精彩,但也有学者有一些担忧。

其中,华盛顿大学的东谈主工智能伦理学大师Os Keye就提到,关于因患有唐氏轮廓征、中风等疾病而导致面部瘫痪的东谈主群,依赖读唇的语音识别还非凡旨吗?

在微软和卡内基梅隆大学的一篇论文中,无情了东谈主工智能公正性计议道路图,指出访佛于 AV-HuBERT 的面部分析系统的某些方面可能不适用于患有唐氏轮廓症、软骨发育不全(损伤骨骼孕育)和“导致特征性面部相反的其他条目”等。

Mohamed 强调 AV-HuBERT 只眷注唇部区域来捕捉唇部盛开,而不是系数这个词面部。他补充说,与大多数 AI 模子访佛,AV-HuBERT 的性能将“与考研数据中不同东谈主群的代表性样本数目成正比”。

“为了评估咱们的步调,咱们使用了公开可用的 LRS3 数据集,该数据集由牛津大学计议东谈主员于 2018 年公开提供的 TED Talk 视频构成。由于该数据集不代表残疾言语者,因此咱们莫得预期性能下跌的特定百分比,”Mohamed 说。

Meta 示意,它将“连接在配景噪声和言语者相通很常见的平日场景中进行基准测试和开垦改良视听语音识别模子的步调。”